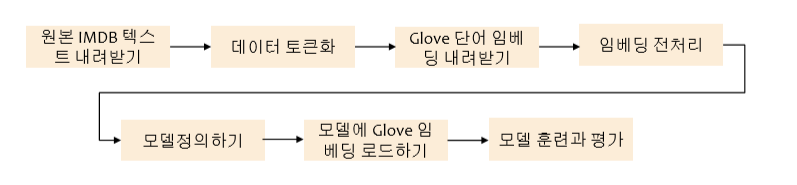

- 원본 데이터 aclImdb 불러오기

import os

imdb_dir = './datasets/aclImdb'

train_dir = os.path.join(imdb_dir, 'train')- 원본데이터 전처리하기

# fname[-4:] == ".txt" 이부분은 .txt를 뒤에서부터 -1로 시작해서 -4까지를 뜻함

labels = []

texts = []

for label_type in ['neg', 'pos']:

dir_name = os.path.join(train_dir, label_type)

for fname in os.listdir(dir_name) :

if fname[-4:] == '.txt':

f = open(os.path.join(dir_name, fname), encoding = 'utf8')

texts.append(f.read())

f.close()

if label_type == 'neg':

labels.append(0)

else :

labels.append(1)- 원본데이터 텍스트를 토큰화 하기

from keras.preprocessing.text import Tokenizer

from keras.preprocessing.sequence import pad_sequences

import numpy as np

maxlen=100 # 100개 단어 이후는 버림

training_samples = 200 # 훈련 샘플은 200ro

validation_samples = 10000 # 검증샘플

max_words = 10000 # 가장 빈도 높은 10000개 단어만

tokenizer = Tokenizer(num_words = max_words)

tokenizer.fit_on_texts(texts)

sequences = tokenizer.texts_to_sequences(texts)

word_index = tokenizer.word_index

print('%s개의 고유한 토큰을 찾았습니다.' % len(word_index))data = pad_sequences(sequences, maxlen=maxlen)

labels = np.asarray(labels)

print('데이터 텐서의 크기 : ', data.shape)

print('레이블 텐서의 크기 : ', labels.shape)

# 데이터를 훈련 세트와 검증세트로 분할

# 샘플이 순서대로 있기 때문에 먼저 섞음

indices = np.arange(data.shape[0])

np.random.shuffle(indices)

data = data[indices]

labels = labels[indices]

x_train = data[:training_samples]

y_train = labels[:training_samples]

x_val = data[training_samples:training_samples + validation_samples]

y_val = labels[training_samples:training_samples+validation_samples]- GloVe 단어 임베딩 파일 파싱하기

glove_dir = './datasets/'

embeddings_index = {}

f = open(os.path.join(glove_dir, 'glove.6B.100d.txt'),

encoding="utf8")

for line in f:

values = line.split()

word = values[0]

coefs = np.asarray(values[1:], dtype='float32')

embeddings_index[word] = coefs

f.close()

print("%s개의 단어 벡터를 찾았습니다." %len(embeddings_index))- GloVe 단어 임베딩 행렬 준비하기

embedding_dim = 100

embedding_matrix = np.zeros((max_words, embedding_dim))

for word, i in word_index.items() :

embedding_vector = embeddings_index.get(word)

if i<max_words :

if embedding_vector is not None:

embedding_matrix[i] = embedding_vector- 모델 정의하기

from keras.models import Sequential

from keras.layers import Embedding, Flatten, Dense

model = Sequential()

model.add(Embedding(max_words, embedding_dim,

input_length=maxlen))

model.add(Flatten())

model.add(Dense(32, activation='relu'))

model.add(Dense(1, activation='sigmoid'))

model.summary()

- 사전 훈련된 단어 임베딩을 Embedding 층에 로드하기

## 사전 훈련된 단어 임베딩을 Embedding 층에 로드하기

model.layers[0].set_weights([embedding_matrix])

model.layers[0].trainable = Falsemodel.compile(optimizer='rmsprop',

loss='binary_crossentropy',

metrics=['acc'])

history = model.fit(x_train, y_train,

epochs=10, batch_size=32,

validation_data=(x_val, y_val))

model.save_weights('pre_trained_glove_model.h5')

- 그래프 표현

import matplotlib.pyplot as plt

acc = history.history['acc']

val_acc = history.history['val_acc']

loss = history.history['loss']

val_loss = history.history['val_loss']

epochs = range(1, len(acc) +1)

plt.plot(epochs, acc, 'bo', label='Training acc')

plt.plot(epochs, val_acc, 'b', label = 'Validation acc')

plt.title('Training and validation accuracy')

plt.legend()

plt.legend()

plt.figure()

plt.plot(epochs, loss, 'bo', label='Training loss')

plt.plot(epochs, val_loss, 'b', label='Validation loss')

plt.title('Training and validation loss')

plt.legend()

plt.show()

- ##6-14

### 6-14

## 사전 훈련된 단어 임베딩 하지않고 같은 모델 훈련하기

from keras.models import Sequential

from keras.layers import Flatten, Dense, Embedding

model = Sequential()

model.add(Embedding(max_words, embedding_dim, input_length=maxlen))

model.add(Flatten())

model.add(Dense(1, activation='sigmoid'))

model.summary()

model.compile(optimizer='rmsprop',

loss='binary_crossentropy',

metrics=['acc'])

history = model.fit(x_train, y_train,

epochs=10,

batch_size=32,

validation_data=(x_val, y_val))

model.save('train_model.h5')- 그래프

### 6-8

texts : 문장

labels : 레이블

### 6-9

토큰화

tokenizer -> 단어 10000개 추츨 -> index 생성 (단어:index = key:value)

sequence -> 문장을 index로

word_index : 사전

data : 길이 -> 단어 100 (상수는 사용자정의)

==> training data, validation data 만듦

### 6-12

Embedding(단어의개수, 한 단어를 얼마만한 길이로 표현할지, input_length=maxlen)

한 단어를 얼마만한 길이로 표현할지 : 표현할수있는 길이보다 커야함

.. 내일은....

내려받은 embedding 데이터를 내것과 어떻게 결합시킬것인가,,?

'딥러닝' 카테고리의 다른 글

| 0812 텐서플로 기초 (0) | 2019.08.12 |

|---|---|

| 0812 LSTM 텍스트 생성모델 구현 (온도 샘플링) (0) | 2019.08.12 |

| 0807 17장 RNN [로이터 뉴스 카테고리 분류하기] (0) | 2019.08.07 |

| 0807 6장 텍스트 데이터 다루기 [Embedding층에 사용할 IMDB 데이터 로드하기] (0) | 2019.08.07 |

| 0807 미세조정 fine-tuning (0) | 2019.08.07 |

![0807 텍스트 데이터 다루기2 [모든 내용 적용하기]](https://img1.daumcdn.net/thumb/R750x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbE7r1z%2Fbtqxhy6Aeet%2F3ZBrXGbPyssSgpZ9DVcUU0%2Fimg.png)